Nvidia Outs Grace CPUスーパーチップアームサーバーラインナップ、2023年初頭に出荷

独自のArmベースのサーバーCPUのラインナップを構築するというNvidiaの決定は、GraceCPUSuperchipとGraceHopperSuperchipと呼ばれ、CPUとGPUを同じボックスに収めた完全なシステムを構築するという同社の方針を示しています。NvidiaがComputex2022で、いくつかの主要なサーバーOEMが2023年前半に

新しいArmCPUとHopperGPUに基づく数十のリファレンスシステムを提供すると発表したため、このイニシアチブは今日現実に近づきました。以下に分類すると、既存のリファレンスサーバーのラインナップと共存するため、同社は当面の間、AMDおよびIntelのx86プロセッサを引き続きサポートします。

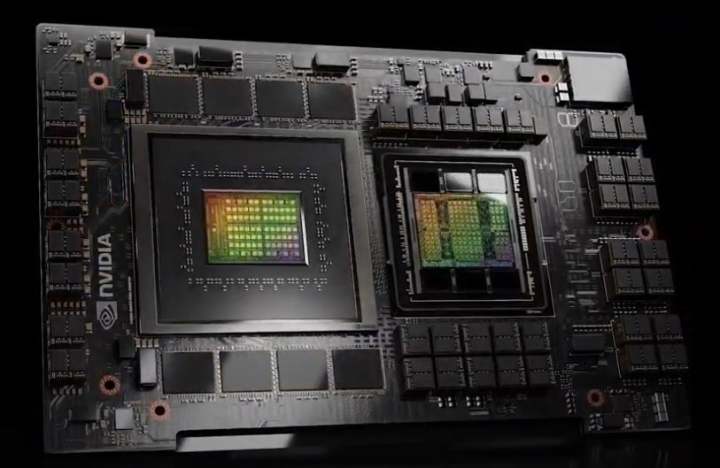

簡単に言うと、NvidiaのGrace CPU Superchipは、データセンター用に設計された同社初のCPU専用Armチップであり、1つのマザーボードに2つのチップとして搭載されています。一方、Grace Hopper CPU Superchipは、同じボード上にHopperGPUとGraceGPUを組み合わせています。 。NeoverseベースのCPUはArmV9命令セットをサポートし、システムにはNvidiaの新しくブランド化されたNVLink-C2C相互接続技術と融合した2つのチップが付属しています。

全体として、Nvidiaは、Grace CPU Superchipが、ハイパースケールコンピューティング、データ分析、科学計算などの幅広いアプリケーション向けに2023年初頭に出荷されたときに、市場で最速のプロセッサになると主張しています。(ここでシリコンの詳細を読むことができます。)

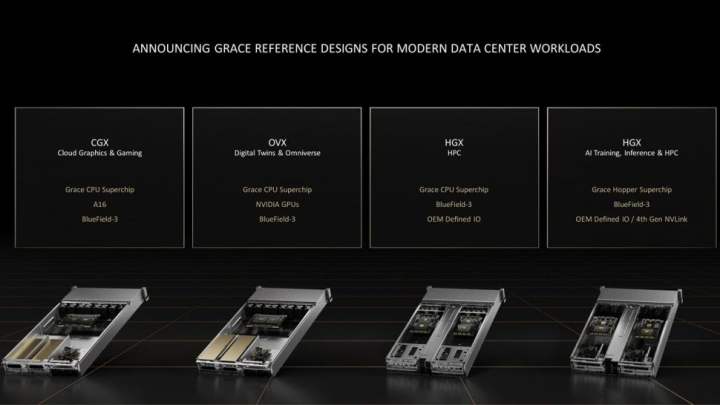

Asus、Gigabyte、Supermicro、QCT、Wiwynn、Foxconnなどの多数の優良OEM / ODMは、2023年前半に発売が計画されている数十の新しいリファレンスサーバー設計を持っており、NvidiaがそのGraceで順調に進んでいることを示していますCPUシリコン。OEMは、サーバーとベースボードの設計図を含むNvidiaの4つのリファレンスデザインの1つから各サーバーデザインを作成します。これらのサーバーは1Uおよび2Uのフォームファクタで利用でき、前者は液体冷却が必要です。

クラウドグラフィックスおよびゲームアプリケーション用のNvidiaCGXシステムには、NvidiaのA16GPUとペアになったデュアルCPUGraceSuperchipが付属しています。Nvidia OVXサーバーは、デジタルツインおよびオムニバースアプリケーション用に設計されており、デュアルCPU Graceも付属していますが、多くの異なるNvidiaGPUモデルとのより柔軟なペアリングが可能です。

NvidiaHGXプラットフォームには2つの種類があります。1つ目はHPCワークロード向けに設計されており、デュアルCPU Graceのみが付属し、GPUは付属せず、OEM定義のI/Oオプションが付属しています。一方、左端には、Grace CPU + Hopper GPU Superchip、OEM定義のI / O、および第4世代のオプションのサポートを備えたAIトレーニング、推論、HPCワークロード向けのよりフル機能のHGXシステムが表示されます。 NVLinkスイッチを介したサーバー外部接続用のNVLink。

特に、NvidiaはCPU + GPU Grace Hopper SuperchipモデルでNVLinkオプションを提供しますが、デュアルCPUGraceSuperchipを搭載したシステムには提供しません。

ここでは、HGXシステムに電力を供給できる2つの異なる2Uブレードを見ることができます。デュアルCPU「HGGXrace」CPUスーパーチップブレードは、最大1TBのLPDDR5xメモリを備え、最大1TB /秒のメモリ帯域幅を提供し、500W TDPエンベロープに準拠し、液体または空気のいずれかで冷却でき、1つあたり2つのブレードをサポートします。ラックあたり最大84ノードのノード。

HGXの「GraceHopper」スーパーチップブレードには、HopperGPUとペアになった単一のGraceCPUが付属しており、512 GBのLPDDR5xメモリ、80 GBのHBM3、および最大3.5 TB/sのメモリスループットを提供します。ご想像のとおり、GPUが追加されているため、このブレードにはより高い1000W TDPエンベロープが付属しており、空冷または液体冷却のいずれかが付属しています。この大きなブレードは、HGXグレースホッパーシステムをラックあたり42ノードに制限します。

当然のことながら、Nvidiaは、これらすべてのシステムに、同社がソリューションプロバイダーになるのに役立つ他の重要な追加機能を提供しています。Mellanox買収の成果として登場する400 Gbps Bluefield-3データ処理ユニット(DPU)です。これらのチップはCPUから重要な作業をオフロードし、合理化されたネットワーキング、セキュリティ、ストレージ、および仮想化/オーケストレーション機能を可能にします。

NvidiaはすでにIntelとAMDの両方のx86CPUで利用可能なCGX、OVX、およびHGXシステムを持っており、同社はこれらのサーバーを引き続き提供し、IntelとAMDシリコンで新しいリビジョンを開発する予定であると語っています。

「x86は非常に重要なCPUであり、今日のNvidia GPUのほぼすべての市場に存在します。引き続きx86をサポートし、ArmベースのCPUを引き続きサポートして、市場のお客様にどこでも選択できるようにします。加速コンピューティングを導入したいと考えています」と、Nvidiaの製品管理およびマーケティング担当シニアディレクターであるPareshKharya氏は語っています。

ただし、それはNvidiaがパフォーマンスパンチを引き出すという意味ではありません。同社は最近、IntelのIce Lakeと直接天気予報で、Grace CPUのデモを行い、Armチップの速度が2倍、効率が2.3倍であると主張しました。これらの同じIntelチップは、現在NvidiaのOVXサーバーに電力を供給しています。

同社もAMDを惜しまなかった。Nvidiaはまた、そのGrace CPU Superchipは、現在のDGXA100システムで使用している2つの前世代の64コアEPYCRome7742プロセッサよりもSPECrate_2017_int_baseベンチマークで1.5倍高速であると主張しています。

NvidiaのCPUへの最初の進出がその主張に応えているかどうかはすぐにわかります。リファレンスCGX、OVX、およびHGXシステムは、2023年の前半に出荷されます。

関連ニュース

Tom's Hardware・2022-06-03

Tom's Hardware・2022-06-03

Tom's Hardware・2022-06-03

Tom's Hardware・2022-06-01

Tom's Hardware・2022-05-31

Tom's Hardware・2022-05-31

みんなの自作PC

![[70万]RTX3080 12900K 搭載エヴァコラボゲーミングPC(でも正直70万あったら3090Ti乗せてもおさまるから見た目追い求める人以外は3090Ti買ったほうがいい)](https://cdn.jisaku.com/upload/7c/noRgcuZik3ymkn/280.jpg)